Agentic AI: Doanh nghiệp vẫn chưa sẵn sàng đâu!

Bài viết này nhằm làm rõ sự nhầm lẫn khi nhiều người coi ChatGPT/Gemini là "AI agent" và những thách thức tiềm tàng của hệ thống Agentic AI.

Mới ngày nào còn là mấy con chatbot AI, mấy cái tool vẽ vời bằng AI, giờ nó đã "tiến hóa" thành "AI agent" – mấy hệ thống AI tự xử một chuỗi task mà không cần mình chỉ lệnh cụ thể từng bước. Nghe đã cái lỗ tai hen? 😆

Chuyện này rồi sẽ đi về đâu thì chưa ai dám chắc, nhưng theo tui có lẽ DN chưa sẵn sàng đâu...

AI càng tiến hoá thì rủi ro càng nhiều (hiện đại thì... hại điện)

Đối mặt với nào là AI "ảo giác" (hallucination), deepfake tràn lan, nguy cơ mất việc, vi phạm bản quyền, kết quả phân biệt đối xử, lộ lọt thông tin cá nhân,...

Trước những thử thách này các DN cần phải:

1/ Nhận diện mấy rủi ro tiềm ẩn cho công ty mình khi xài AI thả cửa.

2/ Xây dựng nguồn lực nội bộ cần thiết để né mấy “cơn ác mộng” không ngờ đến

3/ Nâng cấp (đào tạo) nhân viên để họ biết cách xài mấy nguồn lực đó, cộng thêm óc phán đoán được cập nhật liên tục

Mục số (2) và (3) xin phép HIGHLIGHT & IN ĐẬM !

(Bởi vậy nói AI đẻ ra thêm việc mới cũng ko sai)

(*) Disclaimer: Bài này rất dài, một phần do tui bị "overthinking", phần còn lại do tham khảo từ nhiều nguồn trên internet với cả... bị chị Gemini AI thông não 😁

(xin nhắc lại: tui không phải là chuyên gia, đây là thông tin/kiến thức mà tui tìm hiểu được)

Tui sẽ cố gắng giải thích từng "loại" AI cùng ví dụ để mọi người dễ hình dung, sau đó sẽ nói về việc vì sao tui nghĩ rằng "trùm cuối" AI agent system sẽ rất nguy hiểm, nếu không tìm cách quản lý hoặc đào tạo ra "người quản lý" thì có thể tạo ra thảm họa cho doanh nghiệp và thương hiệu.

---

DZÔ!

Để hiểu rõ hơn về những "loại" AI, chúng ta đi ngược về quá khứ một chút nhé

Ở giai đoạn trước kia (khoảng chừng 2020 đổ về trước), hầu hết các tổ chức/giải pháp quản lý rủi ro AI được xây dựng chủ yếu để xử lý những tác hại tiềm ẩn của AI "hẹp" ("Narrow AI" dịch vậy đúng không nhỉ? 😂)

AI "Hẹp" (Narrow AI)

Còn gọi là AI "truyền thống" hay "mô hình dự đoán", việc của nó là đưa ra dự đoán trong một lĩnh vực hẹp.

Ví dụ phổ biến là phần mềm nhận diện khuôn mặt và các mô hình chấm điểm (một số ví dụ khác: dự đoán rủi ro vỡ nợ thế chấp, khả năng là ứng viên tốt cho công việc, v.v.)

Có thể hình dung "Narrow AI" giống như "Micro SaaS" vậy, chúng gần như chỉ có một nhiệm vụ cụ thể.

Với AI "hẹp", các rủi ro nổi bật bao gồm kết quả mang tính thiên vị (bias) hoặc phân biệt đối xử, không giải thích được AI đưa ra kết quả như thế nào.

Hầu hết các công ty bắt đầu chương trình kiểm soát rủi ro bằng cách cố gắng giảm thiểu tác hại có thể có của AI "hẹp".

Có 4 điều quan trọng cần hiểu về cách chúng được xây dựng:

Bối cảnh (context) sử dụng AI "hẹp" thường được xác định trước

Ví dụ, nếu bạn phát triển AI đọc CV, khả năng cao nó sẽ được dùng trong tuyển dụng. Hoặc bạn phát triển AI đọc biển số xe, khả năng cao nó được dùng trong lĩnh vực giao thông / bãi giữ xe.

Có vài trường hợp khác có thể ít rõ ràng hơn – ví dụ: phát triển phần mềm nhận diện khuôn mặt có thể được sử dụng trong nhiều bối cảnh khác nhau (chấm công, xác thực, phát hiện gian lận, phân tích cảm xúc,…)

Cần chuyên viên dữ liệu (data analysis) để đánh giá rủi ro, theo dõi hiệu suất, giảm thiểu rủi ro và giải thích cách AI hoạt động

Người dùng cuối (end user) chỉ đóng vai trò gửi dữ liệu cho công cụ, mà rất có thể họ không tự tay tạo ra dữ liệu đó

Ví dụ: chuyên viên nhân sự không viết CV, chuyên viên bảo hiểm không điền đơn đăng ký,...

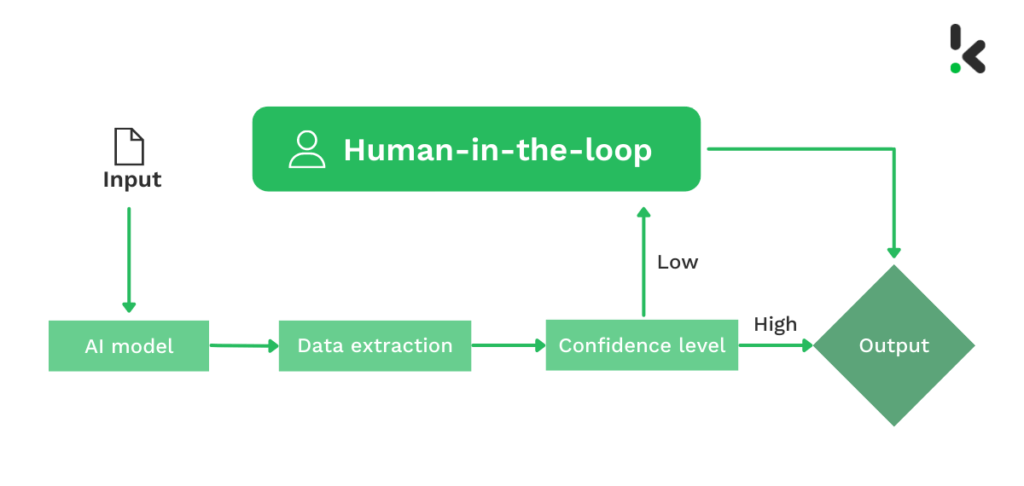

Cần có "con người trong cuộc" (human in the loop) với chuyên môn để kiểm tra đầu ra của AI & làm gì đó tiếp theo

Ví dụ: dù AI "hẹp" có thể dựa vào chỉ số trong xét nghiệm dự đoán khả năng ai đó mắc bệnh tiểu đường trong hai năm tới, thì vẫn cần một bác sĩ sẽ diễn giải đầu ra đó và đưa ra lời khuyên/đơn thuốc liên quan cho bệnh nhân.

Đầu ra được tạo ra với tốc độ con người có thể xử lý, và họ có khả năng kiểm tra đầu ra một cách có trách nhiệm.

Việc giám sát và can thiệp có thể tương đối đơn giản

Các công cụ đánh giá hiệu suất thì đầy rẫy, và nếu AI hoạt động kém ở một số chỉ số liên quan, người ta có thể ngừng sử dụng nó.

Sự gián đoạn do ngừng sử dụng công cụ AI "hẹp" này là khá hạn chế (kiểu như lỡ mà máy bị hỏng thì bác sĩ vẫn có thể phán đoán được bằng kiến thức, kinh nghiệm hoặc kỹ năng chuyên môn)

Tức là, với AI "hẹp", các tổ chức sẽ vẫn cần nhiều "con người ở giữa" (human in the loop) để can thiệp, đó là lý do chúng thất thế khi "thế hệ tiếp theo" xuất hiện 👇

---

Ok, tới giai đoạn 1-2 năm gần đây, từ khi ChatGPT xuất hiện, chúng ta sẽ thấy một khái niệm lên là:

AI Tạo Sinh (Generative AI)

Với AI tạo sinh (lõi là các mô hình ngôn ngữ lớn - LLM), mọi thứ đã thay đổi khá đột ngột:

Bối cảnh triển khai bùng nổ:

Người ta dùng LLM cho đủ thứ chuyện.

Hãy nghĩ đến vô số cách chúng có thể được sử dụng trong mọi công ty, mọi phòng ban, mọi vai trò, cho mọi tác vụ. Rồi cộng thêm vài ngàn cách dùng sáng tạo khác nữa.

Điều này làm cho việc kiểm tra "mô hình sẽ hoạt động như thế nào trong bối cảnh định sử dụng" bắt đầu trở nên khó xác định.

Việc giám sát AI "ngoài tự nhiên" (😆) trở nên vô cùng khó khăn:

Vì có quá nhiều bối cảnh triển khai, các nhà phát triển AI không thể lường trước được mọi thứ, chứ đừng nói đến việc đưa ra các biện pháp giảm thiểu rủi ro phù hợp cho tất cả.

Đối với doanh nghiệp, việc giám sát AI khi nó hoạt động trong những bối cảnh khó lường này (trước khi mọi thứ đi chệch hướng mà không ai để ý) trở nên rất quan trọng.

Ví dụ: một nông trại sử dụng AI nghiên cứu thuốc trừ sâu nhưng AI trả ra loại chỉ dùng cho trồng hoa mà không phải dành cho trồng rau củ quả, khó mà các nhà phát triển AI lường trước được việc này, và cũng khó mà chủ DN lường trước được nhân viên của mình sẽ dùng vào mục đích như thế này.

Tuy nhiên "Con người trong cuộc" (human in the loop) vẫn còn handle được - nhưng chắc chắn cần đào tạo thêm!

Ví dụ, LLM thường xuyên đưa ra những tuyên bố sai lệch (hay còn gọi là "ảo giác" - hallucination)

Người có kiến thức hoặc có trách nhiệm thì sẽ phát hiện ra được ngay, đơn cử như các chuyên gia đọc báo cáo tài chính hoặc các kỹ sư lập trình viên nhiều kinh nghiệm.

Nhưng nếu người dùng không được đào tạo phù hợp để kiểm tra thông tin từ LLM, thì các tổ chức nên chuẩn bị tinh thần nhân viên thường xuyên tạo ra các báo cáo và tài liệu đối nội lẫn đối ngoại (thậm chí sản phẩm) chứa thông tin sai lệch. Banh! 🤪

Người dùng "AI tạo sinh" cần được đào tạo thêm để sử dụng CÓ TRÁCH NHIỆM:

Đó là vì trong khi đầu ra của AI "hẹp" chủ yếu phụ thuộc vào cách các nhà khoa học dữ liệu xây dựng AI, đầu ra của AI tạo sinh lại phần lớn phụ thuộc vào prompt mà người dùng cuối nhập vào (tức là nếu thay đổi prompt => thay đổi đầu ra)

Điều này có nghĩa là cần phải prompt một cách có trách nhiệm: Người dùng cần học cách viết prompt với đầy đủ bối cảnh phù hợp với chuyên ngành của DN, đặc biệt lưu tâm đến bảo mật và quyền riêng tư.

Ví dụ: không nên đưa dữ liệu nhạy cảm của công ty/cá nhân cụ thể vào một LLM gửi dữ liệu đó cho bên thứ ba không đủ tín nhiệm (tui thấy nhiều tổ chức ở VN mình đang làm như thế này lắm rồi)

Đánh giá và giảm thiểu rủi ro diễn ra ở nhiều nơi hơn:

Hầu hết các tổ chức đang mua mô hình từ các công ty như Microsoft, Google, Anthropic, hoặc OpenAI thay vì tự xây dựng.

Các nhà phát triển ở những công ty đó có tham gia vào việc giảm thiểu rủi ro ở một mức độ nào đó, nhưng những biện pháp giảm thiểu đó vẫn còn mang tính... chung chung.

Khi doanh nghiệp có các nhà khoa học dữ liệu riêng sửa đổi mô hình đã được huấn luyện trước (fine-tune mô hình) – dù ở cấp doanh nghiệp hay phòng ban – họ cũng tạo ra nhu cầu đánh giá rủi ro mới.

Việc này có thể gây phức tạp hơn nhanh chóng:

Có nhiều điểm có thể thực hiện các đánh giá như vậy (cá nhân, phòng ban hay doanh nghiệp?), và không rõ liệu chúng có cần thiết trước và sau mỗi lần fine-tune hay không.

Ai nên thực hiện đánh giá rủi ro nào vào thời điểm nào?

Ai là người đánh giá mức độ hiệu quả?

Theo tui biết, đối với những tổ chức đã xây dựng các chương trình rủi ro đạo đức AI/AI có trách nhiệm, các rủi ro được thảo luận bên trên đã được bao gồm (mặc dù mức độ bao phủ/quản lý tốt đến đâu phụ thuộc vào chương trình được xây dựng, triển khai và duy trì tốt như thế nào).

Nhưng khi AI phát triển nhanh, các chương trình đó bắt đầu "gãy" dưới sức ép của sự phức tạp tăng lên chóng mặt, như chúng ta sẽ thấy sau đây 👇

---

Quá khứ, hiện tại xong rồi, bây giờ chúng ta du hành tương lai (gần) nhé:

(Tui nói "gần" là vì nó đang diễn ra rồi, và mọi người sẽ được thấy sớm thôi)

AI Đa Mô Hình (Multi-Model AI) và AI Agent (hay còn gọi là Agentic AI)

Giờ thì mọi thứ trở nên phức tạp kinh khủng, bởi vì AI "hẹp" và "AI tạo sinh" là những thành phần để tạo ra các hệ thống phức tạp hơn - Agentic AI ("AI tự hành")

Tui sẽ thử chia ra từng cấp độ.

Tui thấy có nhiều cách để phân chia các cấp độ này sau khi kham khảo khá nhiều nguồn trên internet, nhưng mục đích ở đây là để bạn hình dung được sự phức tạp dễ dàng leo thang nhanh chóng như thế nào, nên tạm như sau:

Cấp độ 1: Multi-modal AI

Bạn lấy một con LLM và kết nối nó với một AI tạo sinh khác – chẳng hạn, một con chuyên tạo video clip. Trong trường hợp này, bạn có thể bảo LLM của mình tạo ba video khác nhau về những cuộc phỏng vấn hài hước (giống trend Veo 3 vừa rồi), và nó có thể kết nối với một công cụ AI tạo video để làm điều đó.

Hoặc bạn có thể kết nối LLM của mình với một AI "hẹp" và một cơ sở dữ liệu: bạn có thể bảo LLM kết nối với cơ sở dữ liệu CV để thu thập CV cho một vị trí cụ thể, chạy chúng qua AI "hẹp" chấm điểm CV, và báo cáo năm kết quả hàng đầu.

Giờ bạn đã có AI đa mô hình (Multi-modal AI) 😎

Cấp độ 2: Next Level of Multi-modal AI

Kết nối LLM của bạn với 30 cơ sở dữ liệu, 50 AI "hẹp", 5 AI tạo sinh, và toàn bộ Internet.

Không biết gọi tên cho giai đoạn này là gì (kiểu là bản phức tạp hơn của cấp độ 1 thôi), chỉ cần nhớ rằng Internet chứa đủ thứ thông tin điên rồ, thiên vị, sai lệch mà AI của bạn có thể lấy về.

Tới lúc mệt mỏi rồi đó! 😅

Cấp độ 3: Multi-modal AI Agent

Thêm vào AI đa mô hình của bạn khả năng thực hiện các hành động kỹ thuật số cụ thể!

Ví dụ: thực hiện các giao dịch tài chính 🥶

Giờ bạn đã có AI "agent" đa mô hình (Multi-modal AI Agent).

Cấp độ 4: AI Agent Cluster

Cho AI "agent" đa mô hình của bạn khả năng "nói chuyện" với các AI "agent" đa mô hình khác trong tổ chức của bạn.

Giờ bạn có AI "agent" đa mô hình, đa tác nhân nội bộ.

Bắt đầu thấy "đa vũ trụ" AI trong DN của mình chưa? 🫠

Cấp độ 5: Multi-cluster AI Agent

Cho AI "agent" đa mô hình, đa tác nhân nội bộ của bạn khả năng "giao lưu" với các AI "agent" bên ngoài tổ chức của bạn.

Giờ thì bạn có một "mớ bòng bong chóng mặt" với rủi ro KHÔNG thể lường trước được 😳

Lúc này ai sai ai đúng (hay phải viết "AI sai AI đúng" nhỉ? 😂), sai chỗ nào, tại sao sai,... gần như không thể dò ra được nữa rồi.

Hãy nhìn qua sơ đồ sau cho dễ hình dung:

Tiến trình này cho các nhà quản lý thấy tổ chức của họ đang ở đâu trên "con đường tiến hóa phức tạp" này.

Quan trọng hơn, họ cần xây dựng những khả năng gì trước khi chuyển sang giai đoạn tiếp theo.

Theo những gì tui quan sát được, chưa có tổ chức nào tại Việt Nam có đủ nguồn lực nội bộ hoặc nhân sự được đào tạo để xử lý nổi CẤP ĐỘ 2, chứ đừng nói đến các cấp độ tiếp theo.

Một số chuyên gia AI top đầu mà tui biết tại VN, hầu hết vẫn còn đang “chật vật” ở CẤP ĐỘ 3 mà thôi

(trong đó không có tui, tại tui hổng phải chuyên gia, tui chỉ là “tò mò nghiên cứu sinh” thôi, và đương nhiên cũng chưa chạm nổi được cấp độ này 😂)

---

Bây giờ chúng ta sẽ bàn về lý do tại sao những thử thách này lại trở nên khó nhằn hơn nhiều:

Ai nên thực hiện đánh giá rủi ro nào vào thời điểm nào trở nên CỰC KỲ khó xác định

Có quá nhiều điểm tương tác (và đừng quên các đánh giá rủi ro cần thiết trong một mô hình đơn lẻ) đến nỗi việc thực hiện đánh giá rủi ro ở mỗi điểm là không khả thi về mặt thực tế.

Cần phải phân tích chi phí/lợi ích cẩn thận để xác định đâu là cần thiết và đâu là "có thì tốt" liên quan đến mức độ chấp nhận rủi ro của tổ chức.

Khả năng của người dùng cuối (tức là "con người trong cuộc" / human in the loop)

Hiệu quả của việc đứng ra giám sát đầu vào và đầu ra của hệ thống AI đã không còn đủ mạnh ngay cả ở Cấp độ 1, chứ đừng nói đến Cấp độ 5

Ở giai đoạn trước kia (Narrow AI) thì mọi thứ còn trong tầm tay được (như đã viết ở đoạn đầu)

Chứ lúc này đơn giản là có quá nhiều dữ liệu để bất kỳ con người nào có thể xử lý trong thời gian thực (hoặc thậm chí sau đó). Con người theo không kịp AI rồi!

Như vậy, với vai trò người đứng đầu, quyết định trở nên khó khăn hơn: "TRIỂN KHAI" hay "KHÔNG TRIỂN KHAI"?

Giờ giả sử mọi người biết cách kiểm tra và đánh giá trước khi tiến hành đi, thì các giám đốc điều hành cấp cao và trưởng nhóm kỹ thuật phải xác định xem các hệ thống AI đã sẵn sàng để sử dụng hay chưa. (Nhắc lại là "GIẢ SỬ" thôi nhé... vì mọi thứ bây giờ mơ hồ lắm)

Hiện tại, hầu hết các tổ chức thiếu các khung đánh giá quan trọng trước khi triển khai này (nếu không muốn nói là chẳng ai kiểm tra gì, và chỉ khi nào nó "có vấn đề" thì mới tìm cách xử lý) => điều này khiến các quyết định được đưa ra có độ rủi ro cao.

Vì không có quyết định triển khai nào có thể xem xét tất cả các khả năng mà mọi thứ có thể đi chệch hướng (đặc biệt là ở Cấp độ 5)

Việc giám sát trong thời gian thực trở nên vô cùng quan trọng.

Nếu không có giám sát thời gian thực, tốc độ mà mọi thứ có thể sụp đổ là "kinh hoàng"

Phải thiết kế các phương pháp để can thiệp vào hệ thống khi hệ thống báo hiệu nguy hiểm.

Tuy nhiên, vì đây là những hệ thống cực kỳ phức tạp tương tác với các hệ thống phức tạp khác - tất cả đều đòi hỏi nguồn lực khổng lồ để vận hành vì một mục đích to lớn nào đó - nên cần có các phương pháp can thiệp làm gián đoạn hệ thống ở mức tối thiểu trong khi giảm rủi ro xuống mức có thể chấp nhận được.

Ví dụ, tốt hơn là xác định mô hình AI "hẹp" số 21 là nguồn gốc của vấn đề và tắt quyền truy cập của nó, mà không phải tắt toàn bộ hệ thống.

(Tuy nhiên, một số rủi ro phát sinh từ chính hệ thống chứ không phải từ bất kỳ node cụ thể nào đó, lúc này có thể cần phải… tắt hệ thống)

Tầm quan trọng của việc NÂNG CẤP đội ngũ nhân viên

Cần có giáo dục và đào tạo chung vượt xa việc xem video tuân thủ 30 phút hàng năm cho tất cả mọi người (này thì ở tập đoàn hay cty lớn có thôi, chứ SME thì thôi quên luôn)

Cần có đào tạo chuyên biệt ít nhất ở cấp phòng ban và trong nhiều trường hợp ở cấp chuyên môn. Việc đào tạo này phải hướng đến việc nhân viên có thể thường xuyên mua, phát triển, tàn trữ, sử dụng và giám sát AI / các hệ thống AI một cách có trách nhiệm và có thể "ngửi thấy mùi nguy hiểm" khi có điều gì đó không ổn.

Đây không phải là đào tạo một lần rồi thôi.

Đây là điều phải được diễn ra liên tục dựa theo sự phát triển của AI mở rộng ra xa hơn sau này (AI phát triển nhanh liên tục mà!)Hình mẫu các công ty thành công nhất mà tui nghĩ đến: Họ đầu tư và tiếp tục đầu tư mạnh vào việc đào tạo nhân viên trước khi triển khai công nghệ, chứ không phải sau khi vấn đề phát sinh.

Cái này tui xin phép nhắc lại 3 lần: ĐÀO TẠO, ĐÀO TẠO, và ĐÀO TẠO!

Bạn không thể kỳ vọng mấy cái này nhân viên phải TỰ TÌM HIỂU được, trước kia cũng không, bây giờ lại càng KHÔNG.

---

Vậy thì... DN cần phải làm gì?

Phần này ý kiến cá nhân thôi, thường thì ngồi phán nó dễ hơn ngồi làm haha (mà anh em có cao kiến gì thì cứ chia sẻ thêm nha)

AI vẫn sẽ tiếp tục phát triển từ các công cụ "hẹp" thành các hệ thống "agent" đa năng phức tạp hoạt động với tốc độ và quy mô vượt qua sự giám sát của con người.

Các tổ chức phải đối mặt với một lựa chọn rõ ràng:

Họ có thể chủ động đối mặt với thử thách ngay bây giờ, khi sự phức tạp vẫn còn có thể quản lý được

Hoặc họ có thể đợi cho đến khi một thất bại thảm khốc (của chính họ hoặc thấy được của người khác) buộc họ phải hành động

Các công ty sẽ phát triển mạnh trong kỷ nguyên AI agent là những công ty nhận ra bước ngoặt này đúng với bản chất của nó:

Đây không chỉ là một bản nâng cấp công nghệ, mà là một sự chuyển đổi cơ bản trong cách các DN quản lý rủi ro, đào tạo nhân viên và đưa ra quyết định.

Họ hiểu rằng việc chuyển từ Cấp độ 1 sang Cấp độ 5 mà không có cơ sở hạ tầng phù hợp và trang bị kiến thức đầy đủ không phải là đổi mới, mà đó là liều lĩnh.

Tin vui là các DN không cần phải làm mọi thứ cùng một lúc.

Họ chỉ cần nghiêm túc đánh giá xem mình đang ở đâu trên "con đường tiến hóa" này, xây dựng các khả năng cần thiết cho cấp độ hiện tại của mình và tạo ra cơ sở hạ tầng để phát triển an toàn sang cấp độ tiếp theo.

Ngoài ra, họ nên đầu tư vào đào tạo nhân viên liên tục và toàn diện, phát triển các hệ thống giám sát mạnh mẽ và tạo ra các quy trình can thiệp (ít nhất là theo giả định, chứ đợi có “tai nạn” xảy ra thì… muộn rồi)

Đó là một thử thách đòi hỏi nhiều công sức & nỗ lực, nhưng các lựa chọn khác thì còn tệ hơn nhiều:

Lao về phía trước một cách liều lĩnh (kiểu cứ làm thôi, sai đâu thì vá đó 🥶)

Hoặc đứng yên một chỗ nhìn DN của mình “rỉ máo” tới khi lịm dần 😅

Nói túm lại là, làm ơn chuẩn bị cho kỹ rồi hãy “đu trend”, đừng có tự tin thái quá, mọi người chưa lường trước được sự thay đổi sẽ diễn ra tới mức độ như thế nào nữa đâu. Các sếp đừng biến cơ hội thành "thảm họa" chỉ vì chủ quan! (thôi thà chậm tí mà chắc còn hơn)

Bài viết tuyệt vời đại ka.